Over de klant

FUGA is een toonaangevend b2b-muziekdistributie-, marketingdiensten- en technologiebedrijf dat een flexibele en aanpasbare aanpak biedt om te voldoen aan de behoeften van contenteigenaren van elke omvang. Een divisie van Downtown Music, FUGA’s geavanceerde muziekdistributietechnologie, gedetailleerde analysesoftware en royalty-boekhoudpakket geven hun klanten de controle die ze nodig hebben om door het digitale landschap te navigeren naarmate hun behoeften evolueren. Met hun klantgerichte houding ten opzichte van het bedrijfsleven helpt FUGA houders van muziekrechten succesvol te worden door hun inhoud op meer dan 250 wereldwijde muziekplatforms, zoals YouTube Music en Spotify, te plaatsen. Met een team van meer dan 200 experts, zijn ze het platform bij uitstek voor onafhankelijke labels, managementbureaus en distributeurs. Dankzij het toonaangevende agnostische platform kunnen hun klanten de diensten kiezen die het beste bij hun bedrijfsplan passen, zodat ze kansen kunnen grijpen en uitdagingen op de digitale muziekmarkt kunnen overwinnen.

Het probleem: een ontbrekende noot in de ML-symfonie

FUGA heeft verschillende data scientists in haar team, die sterke inzichten samenstellen rond hun grote hoeveelheden data. Vroeger construeerden ze modellen die waren georkestreerd met een reeks modulaire Python-scripts en gebruik maakten van een traditionele machine learning-cyclus: gegevensvoorverwerking, feature-engineering, modeltraining, evaluatiefasen en implementatie. Deze processen veroorzaken veel operationele overhead, wat leidt tot een hoge time-to-market en lage ontwikkelingssnelheid. Vanwege hun groeiende interesse in geavanceerde statistische modellen en machine learning heeft FUGA contact opgenomen met Devoteam G Cloud om de adoptie van best practices te versnellen en de time-to-market te verkorten.

Het doel: versnellen, experimenteren en empoweren

In de zoektocht om hun rijkdom aan data volledig te benutten voor het welzijn van artiesten en fans, wil FUGA naadloos meer ML-modellen kunnen ontwikkelen en naar productie kunnen brengen. Dit kan worden bereikt met MLOps. MLOps is voor machine learning wat DevOps is voor softwareontwikkeling. Het brengt gestandaardiseerde, geautomatiseerde en veerkrachtige praktijken met zich mee om de releasesnelheid voor machine learning te verhogen.

Naast de verbeterde snelheid, mikte FUGA op:

- Een volledige serverless architectuur, waardoor ze flexibel kunnen schalen naar hun vereisten en tegelijkertijd de kosten kunnen verlagen in perioden waarin ze minder resources nodig hebben.

- robuuste ML-pipelines, waardoor ze veel flexibiliteit krijgen bij hun experimenten en de reproduceerbaarheid van hun resultaten wordt gegarandeerd.

- het afdwingen van de traceerbaarheid van ML-artefacten, waardoor inzicht wordt verkregen in de exacte status en evolutie van elke afzonderlijke stap van ML-processen.

- gedetailleerde monitoring, dankzij gedetailleerde dashboards met het resourcegebruik, evaluatiestatistieken en andere belangrijke waarden.

Door deze doelen te stellen, wilde FUGA hun algehele ML-praktijken ontwikkelen en daarmee een solide raamwerk veiligstellen voor het bevorderen van hun doelen. Deze transformatie was geworteld in hun inzicht dat het echte einddoel niet alleen de inzet van modellen omvatte, maar ook een strategische basis die zou leiden tot meer vertrouwen bij de inzet van nieuwe ML-modellen, snellere releasecycli en substantiële kostenoptimalisatie.

Om deze doelen te bereiken, ging FUGA een partnerschap aan met Devoteam G Cloud om een van FUGA’s machine learning-modellen aan te passen en solide MLOps-principes te gebruiken. Vervolgens vertrouwden ze op de ondersteuning van Devoteam om FUGA te helpen bij de adoptie van het nieuwe framework in hun machine learning-roadmap.

FUGA profiteert al van het gebruik van verschillende GCP-services, waaronder BigQuery. Met de begeleiding en expertise van onze Google Cloud Partner Devoteam kunnen we nu gebruikmaken van het nieuwste aanbod van Google-services op het gebied van kunstmatige intelligentie. Maar ook van de sterke data-integraties in de cloudservices om onze gegevens in een ultramoderne Machine Learning-omgeving te brengen die gebruikmaakt van de beste MLOps-praktijken.

De oplossing: succes met de Vertex AI Foundations van Devoteam

Het model van dit project pakt een belangrijke uitdaging voor muziekuitgevers aan: het voorspellen van inkomsten op alle beschikbare platforms. Dit zorgt ervoor dat muziekuitgevers hun omzet kunnen voorspellen en die overeenkomstig kunnen plannen. Het ondersteunen van dit model met solide MLOps-principes is van het grootste belang, omdat dit model continu beschikbaar moet zijn, nauwkeurige voorspellingen moet doen en gemakkelijk onderhoudbaar moet zijn door de teams van FUGA.

Gebruikmaken van de Vertex AI Foundations van Devoteam G Cloud

De Vertex AI Foundations, gebouwd door de interne experts van Devoteam G Cloud, diende als raamwerk en integreerde de essentiële componenten die nodig zijn om betrouwbare principes en operaties binnen Vertex AI tot stand te brengen. Dit raamwerk maakt gebruik van een infrastructuur-als-code-aanpak en bevat de noodzakelijke tools om pipelines, componenten, pakketten en containers op de juiste manier met elkaar te verbinden om MLOps op Vertex AI toe te passen.

Het gebruik van de Vertex AI Foundations voor dit project bracht onder meer de volgende voordelen met zich mee:

- Snellere releasecycli: in plaats van zich te concentreren op operationele taken (het bouwen van artefacten, het opnieuw trainen van modellen, het handmatig experimenteren met modelparameters, …), kunnen machine learning-ingenieurs zich concentreren op de kern van hun werk: het bouwen van betere modellen die meer bedrijfswaarde opleveren.

- Verbeterde ontwikkelaarservaring: dankzij de ingebouwde integraties van de Vertex AI Foundations tussen Google Cloud-services, codefragmenten en herbruikbare services is het toevoegen van nieuwe functies aan een ML-project nog nooit zo eenvoudig geweest.

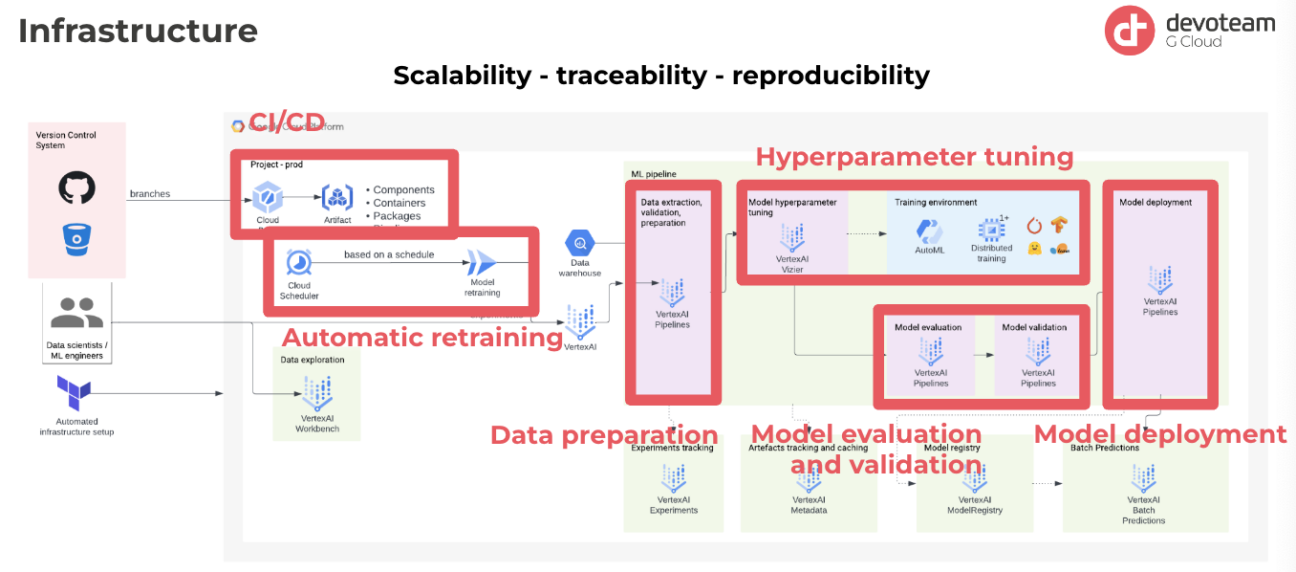

- Schaalbaarheid / traceerbaarheid / reproduceerbaarheid: de Vertex AI Foundations combineert alle Vertex AI- en Google Cloud-services die nodig zijn in uw MLOps-traject, waardoor de vereiste functies worden geboden om modellen met vertrouwen in productie te implementeren.

Technical Solution Framework

- Continue integratie/continue implementatie (CI/CD): De oplossing omvat een CI/CD-pipeline die het maken van artefacten automatiseert. Deze praktijk is essentieel omdat het versiebeheer van elk artefact mogelijk maakt, waardoor volledig inzicht in de gehele ML-pipeline wordt geboden. Dit is gunstig omdat het bij productieproblemen nu mogelijk is om de code van het model, de specifieke pipeline die voor training wordt gebruikt en de exacte gebruikte componenten en pakketten te traceren.

- Geautomatiseerde her-training voor duurzame prestaties: Een ander belangrijk kenmerk is de automatische her-training, die kan worden gepland of geactiveerd door evaluatiestatistieken. Als prestatieverlies wordt gedetecteerd in de productie, kunnen de ML-modellen automatisch opnieuw worden getraind. Deze praktijk sluit aan bij het doel om ervoor te zorgen dat de prestaties van het model in de loop van de tijd relevant blijven.

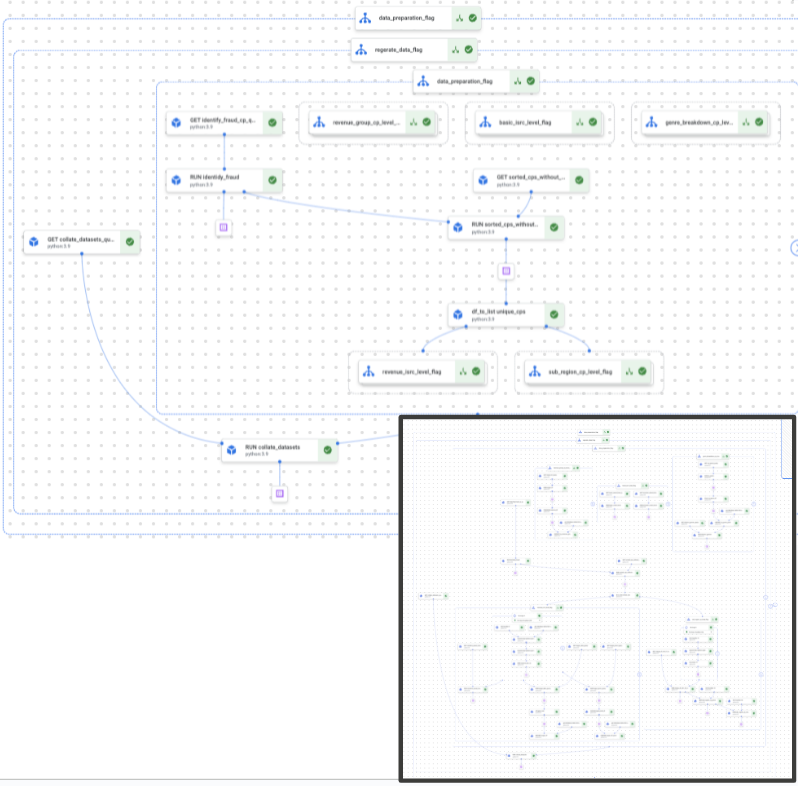

- Verbetering van de gegevensvoorbereiding: Hoewel de gegevensvoorbereiding door de klant werd uitgevoerd, optimaliseerde Devoteam G Cloud het proces in termen van zowel parallellisatie als kosteneffectiviteit. Deze verbetering resulteerde in een aanzienlijke toename in snelheid en efficiëntie. Dit was een cruciale verbetering aangezien de ML-pipeline meer dan 1.000 componenten omvatte.

- Hyperparameterafstemming met Vizier AI: Google’s Vizier AI wordt gebruikt om de optimale modelparameters voor topprestaties te identificeren. De tool beveelt parameters aan op basis van uitgevoerde experimenten en past suggesties iteratief aan het specifieke probleem aan dat wordt aangepakt, wat resulteert in een verfijnd en geoptimaliseerd model. Nadat het beste model is geïdentificeerd, zorgen grondige evaluatie en validatie ervoor dat het kan worden vergeleken met een speciale testset.

- Efficiënte evaluatie en geautomatiseerde implementatie: Modellen die voldoen aan prestatiebenchmarks en validatiecriteria worden toegevoegd aan het modelregister. Het geselecteerde model wordt vervolgens via een volledig geautomatiseerd proces geïmplementeerd in Vertex AI, waardoor de overgang van ontwikkeling naar implementatie eenvoudig wordt.

De oplossing die Devoteam G Cloud ons aanbood heeft alle verwachtingen overtroffen, en ze waren al hooggespannen. Dit zal een groot verschil maken in de richting waar FUGA als bedrijf heen gaat binnen het dataspectrum. Het heeft de basis gelegd voor nieuwe grote stappen in de toekomst. We gaan ervoor zorgen dat we Devoteam’s kennis en expertise optimaal kunnen benutten. Hopelijk kunnen we in de toekomst aan nog meer projecten samenwerken. Ik ben erg blij om aan FUGA te kunnen rapporteren over het geweldige werk dat Devoteam heeft verricht en hoe waardevol het voor ons is geweest.

De methode

Het project begon met de installatie van de Vertex AI Foundations. Zodra de MLOps-infrastructuur was opgezet, konden de engineers van Devoteam G Cloud zich gaan concentreren op de ontwikkeling van de ML-pipeline op basis van de bestaande code van FUGA.

Om de gegevensvoorbereiding en de modelprestaties te verbeteren, werden iteratief verfijningen aangebracht. Grondige documentatie en inzichten werden vervolgens gedeeld met het FUGA-team, waardoor hun begrip van de Vertex AI Foundations en het gebruik ervan werd vergemakkelijkt.

Devoteam G Cloud zal FUGA blijven ondersteunen bij de adoptie van de Vertex AI Foundations in hun routekaart naar meer ML-gebruiksscenario’s. Deze gezamenlijke aanpak zorgt voor een geleidelijke adoptie en impactvolle resultaten in de loop van de tijd voor FUGA en hun klanten.

De resultaten: efficiëntie, kostenoptimalisatie en een basis voor hun ML-praktijken

De voordelen van dit project waren tastbaar voor FUGA: een stijging van de efficiëntie, kostenoptimalisatie en vooral een robuuste basis voor hun ML-praktijken. FUGA heeft nu de kracht om elke stap van de pipeline te monitoren, de oorsprong van elk artefact te traceren en modellen met gemak aan te passen. Om nog maar te zwijgen: het team van FUGA was enthousiast over de samenwerking en de oplossing zal hen enorm helpen in de volgende fase van hun machine learning-traject.

Een nieuwe standaard voor wat we met ons bedrijf op datagebied kunnen doen

Klaar om jouw AI & ML projecten te versnellen met de Vertex AI Foundations, net als Fuga?

Ontdek hoe Devoteam’s Vertex AI Foundations uw ML-projecten kunnen versnellen, waardoor een snellere implementatie, kostenbesparingen en een sterke basis voor succes worden gegarandeerd. Aarzel niet – neem contact op om te starten en blijf voorop met behulp van de nieuwste machine learning-technologie.